Mu77

Web vs corporaciones

Quiénes dominan hoy internet: Creada para compartir libremente conocimiento e información, hoy está en manos de empresas y agencias de inteligencia. Su creador lanzó una campaña para liberarla.

Hace apenas 25 años el científico Tim Berners-Lee patentó el invento más importante de los últimos tiempos: la red de redes o World Wide Web. Y lo hizo a nombre de la humanidad. Lo que Berners-Lee no calculó es que ese monstruo llamado Internet, que imaginó funcionando mediante una estructura descentralizada, asimétrica y horizontal, igual iba a quedar atrapado en manos de unas pocas empresas que hoy poseen el control sobre los flujos de información.

Las revelaciones de Edward Snowden, el espía de la National Security Agency (NSA), ponen ahora de manifiesto la complicidad entre este puñado de empresas y el aparato de espionaje norteamericano y nos obliga a hacernos al menos tres preguntas:

¿Quiénes se adueñaron de Internet?

¿Por qué es peligroso que la web esté concentrada en pocas manos?

¿Por qué el control Internet es un factor clave a nivel geopolítico?

Lo concreto de lo virtual

La Real Academia Española define lo “virtual” como aquello que tiene “existencia aparente, pero no real”. Internet, que a primera vista parece ser algo abstracto e intangible -como una “nube” de datos- funciona gracias a una infraestructura que tiene existencia real, concreta y sólida: un conjunto de tubos submarinos transoceánicos y cables de fibra óptica -complementados por satélites-, por donde circula toda la información de la web.

Esta red de tubos está en manos de unas pocas multinacionales: Verizon, Vodafone, Level3, Viatel e Interoute, AOL, AT&T, British Telecom, Deutsche Telekom, NTT Communications, Qwest, Cogent, SprintLink, TIWS. La más poderosa es la empresa Level 3 Communications, que al fusionarse en 2012 con Global Crossing logró concentrar más del 70% del tráfico de Internet en el mundo, con una facturación anual de 6.376 millones de dólares.

Level 3 posee 161.000 kilómetros de cables de fibra óptica que atraviesan 45 países (en Argentina los tubos llegan, aunque usted no lo crea, a Las Toninas) y es la de mayor presencia en Sudamérica, donde se conectan unos 170 millones de usuarios y circula el 7,3% del tráfico mundial de la web.

Si uno mira un mapa de Latinoamérica que grafique esta red de tubos se va a encontrar con una especie de telaraña en la cual todos sus puntos desembocan en el mismo lugar: el Network Access Point of the Americas (NAP), ubicado en Miami. Se trata de una base de datos que aloja el 90% del tráfico de América Latina.

Esto significa, por ejemplo, que aproximadamente 9 de cada 10 mails enviados desde territorio latinoamericano pasan por Miami antes de llegar a su destino.

El primer grado de concentración se da, entonces, en el nivel de la infraestructura.

Terrorista sos vos

El libro Snowden: Sin un lugar donde esconderse, recientemente editado en Argentina, recopila y sintetiza los documentos filtrados por el ex contratista de la NSA que desnudó las operaciones de espionaje del Estado norteamericano en uno de los casos de filtración más grandes de la historia. Los documentos prueban que Estados Unidos, con la excusa del terrorismo, llegó a interceptar en la web 20 mil millones de comunicaciones por año. Repito: 20 mil millones. Los documentos filtrados por Snowden muestran tutoriales, informes y gráficos que la NSA le daba a sus empleados, por lo cual tienen la virtud de ser didácticos, a pesar del lenguaje encriptado que utilizan.

“El programa llamado Stormbrew le da a la NSA acceso a Internet y saca partido del hecho de que casi todo el tráfico mundial fluye, en algún momento, por la estructura de telecomunicaciones de Estados Unidos”, explica el autor del libro.

Las empresas, total o parcialmente aliadas a la NSA, figuran en los documentos bajo seudónimos, por lo cual ni siquiera Snwoden sabía cuáles eran.

Lo cierto es que uno de los países latinoamericanos que más sufrió el espionaje de la NSA, junto con Venezuela y México, fue Brasil, donde la agencia norteamericana interceptó más de 2.300 millones de comunicaciones, realizó un “espionaje económico” a la gigante Petrobras e hizo un seguimiento personalizado, desde 2011 en adelante, a la actual presidente Dilma Rousseff.

No es casual entonces que Dilma convocara, en abril de este año, la conferencia Net Mundial, un encuentro realizado en San Pablo con especialistas de todo el mundo -entre los que estuvo el propio Berners-Lee- para discutir y redefinir la gobernanza de Internet. Días antes, el Senado brasileño había aprobado el Marco Civil Internet, una legislación sin precedentes que se aleja de las regulaciones internacionales tendientes a la censura de contenidos, priorizando el derecho a la privacidad de los usuarios y proclamando un principio de neutralidad de la web. Esto significa que todos los paquetes de datos deben ser tratados por igual, sin filtros de análisis ni bloqueos, a menos que haya una orden judicial que así lo solicite.

Lo viejo de lo nuevo

Net Mundial culminaría con la aprobación de un acuerdo de principios, pero Wikileaks, que siempre va a un paso adelante, filtró ese documento que ya había sido redactado antes del encuentro. Allí no había referencia a la NSA ni críticas directas contra la vigilancia, lo que desencadenó una ola de quejas y descontento que se manifestó a través de las redes sociales. Surgió incluso la campaña #OurNetMundial (Nuestra Net Mundial) que llegó a tener más repercusión que el discurso oficial y obligó a las autoridades a hacer un cambio de rumbo improvisado.

En la ceremonia de cierre, mientras los asistentes desplegaban máscaras con el rostro de Snowden, la Presidenta Roussef, acorralada por la presión social, proclamó: “El gobierno de Internet debe ser multilateral, multisectorial, democrático y transparente”.

El control del tráfico

Pero la concentración de Internet no se da sólo a nivel de infraestructura. En el terreno de los contenidos, es decir, allí donde se mueve un usuario común desde su computadora, diez empresas privadas controlan el tráfico de la web, de las cuales las seis más importantes son:

Microsoft

Yahoo

Wiki

Amazon

Las cuatro primeras figuran en los documentos filtrados por Snowden como puntos centrales para acceder a información de los usuarios. Así fue como la NSA logró intervenir mails, chats, videos, fotos, datos almacenados, detalles online de redes sociales y transferencias de archivos. Las empresas niegan haber colaborado con la NSA, pero admiten que estaban al tanto de la existencia del programa que lo permitió: PRISM. Lo definen como un sistema técnico menor por el cual otorgaban datos solamente cuando la ley los obligaba, argumento que dista mucho de la verdadera potencialidad de PRISM como programa de espionaje.

Donde se percibe con claridad la colaboración entre la NSA y las empresas privadas es en uno de los documentos filtrados que tiene fecha del 8 de marzo de 2013. Allí se muestran los esfuerzos de Microsoft por facilitarle a la NSA el acceso a sus servicios más usados: Skype, Outlook y SkyDrive. El documento, luego de explicar un avance técnico que permitió acceder con mayor facilidad a ciertas informaciones privadas, celebra: “Este éxito resulta de los muchos meses de colaboración del FBI con Microsoft”.

Google ordena, filtra y manda

Más allá de la complicidad con el aparato del espionaje, la concentración de la web en un puñado de empresas implica otra serie de problemas y desafíos.

Google domina el 40% del tráfico de la web y tiene la capacidad de ordenar, filtrar y controlar el acceso a la información. Lo hace a través de un algoritmo que se actualiza constantemente y que determina qué es pertinente y qué no. El nivel de “pertinencia” que diagnostica el algoritmo no es, en primera instancia, arbitrario, si no que depende de la cantidad de tráfico que genera cada página.

Pero casos como los de Metafilter, una comunidad online que existe desde 1999 y que tiene miles de visitas diarias, puso de manifiesto la capacidad de Google a la hora de invisibilizar una información: al cambiar el algoritmo, Google dejó a Metafilter prácticamente fuera de los buscadores, haciendo caer su tráfico en un 40%. Casos similares ocurrieron en las redes sociales: Twitter dejó afuera de los trending topics (las tendencias que se generan a partir de las palabras más usadas en esa red) a Wikileaks cuando la cuenta @wikileaks era el principal medio para seguir filtrando cables secretos. La empresa del pajarito salió a decir que fue “un error del algoritmo”.

Google ofrece un sistema de publicidad mediante el cual un usuario puede posicionar su página pagando un monto para que aparezca en las listas de búsquedas relacionadas con palabras claves -entre 10 y 20- que el usuario elija. Por ejemplo:

Si deseo que mi página aparezca cada vez que alguien busca “Noticia actual” en Google, debo pagar $0,22 por cada cada click que alguien hace en mi página a través de esa búsqueda.

“Noticas actuales”, cuesta $0,37.

El verbo “vender” vale $4,09 y va aumentando el valor según el grado de especificidad de las combinaciones.

Y así, cada palabra o combinación de palabras tiene un monto distinto, como si estuviéramos frente a un diccionario que en lugar de definiciones tiene aranceles. A través de este sistema, Google pone a la misma altura a las páginas que más visitas tienen -por antigüedad y/o por generación de contenidos- con las que más pagan.

Así, los gigantes que controlan la web en sus distintos niveles son los que imponen las reglas del juego.

Berners-Lee vio cómo su criatura se convirtió en un monstruo en manos de unos pocos, pero lejos de resignarse, creó una campaña por una web abierta, transparente y descentralizada, que más allá de las proclamas sugiere un punto de partida sugerente : Web We Want, es decir, la Web que Nosotros Queremos.

Mu77

La hipótesis Carrasco

Murió el viernes 9 de mayo y hasta sus últimos días estuvo difundiendo los peligros del modelo productivo que tiene en la ciencia su principal cómplice. Defendió sus ideas en asambleas, seminarios y charlas tratando de alertar sobre el peligro de atar la producción de conocimiento a las corporaciones. Dejó un legado: cada vez hay más Carrascos.

(más…)

Mu77

Genes en peligro

Las investigaciones de la Universidad Nacional de Río Cuarto. Por primera vez Fernando Mañas y Delia Aiassa conversan con la prensa sobre sus investigaciones sobre el glifosato y sus daños a la salud. Una entrevista de Darío Aranda.

(más…)

Mu77

Curando a la facu

La Facultad de Ciencias Médicas de Rosario. Damián Verzeñassi es el responsable de que los médicos se reciban luego de hacer su práctica final relevando la salud de los pueblos santafesinos. Así, sistematizaron las enfermedades que se expanden al ritmo del modelo agrotóxico. Las consecuencias.

(más…)

Fumigaciones en PergaminoHace 4 semanas

Fumigaciones en PergaminoHace 4 semanasComienza un juicio histórico por fumigaciones con agrotóxicos

Roberto PïanelliHace 4 semanas

Roberto PïanelliHace 4 semanasAdiós, Capitán Beto

Marcha de jubiladosHace 3 semanas

Marcha de jubiladosHace 3 semanasVideo homenaje a la lucha de jubiladas y jubilados

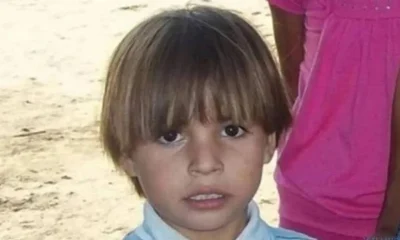

Muerte por agrotóxicosHace 3 días

Muerte por agrotóxicosHace 3 díasConfirman la condena al productor que fumigó y provocó la muerte de un chico de 4 años

IndustricidioHace 4 días

IndustricidioHace 4 díasEn el fin del mundo: ocupación contra la desocupación en Tierra del Fuego